目录

一、论文介绍

基于DEEPJSCC,引入分层编码器,在不同尺度上捕获丰富的语义信息;

编码器和解码器结构相似,相互互补,可以更好的保证语义信息的编码与恢复,提高传输性能。

二、流程介绍

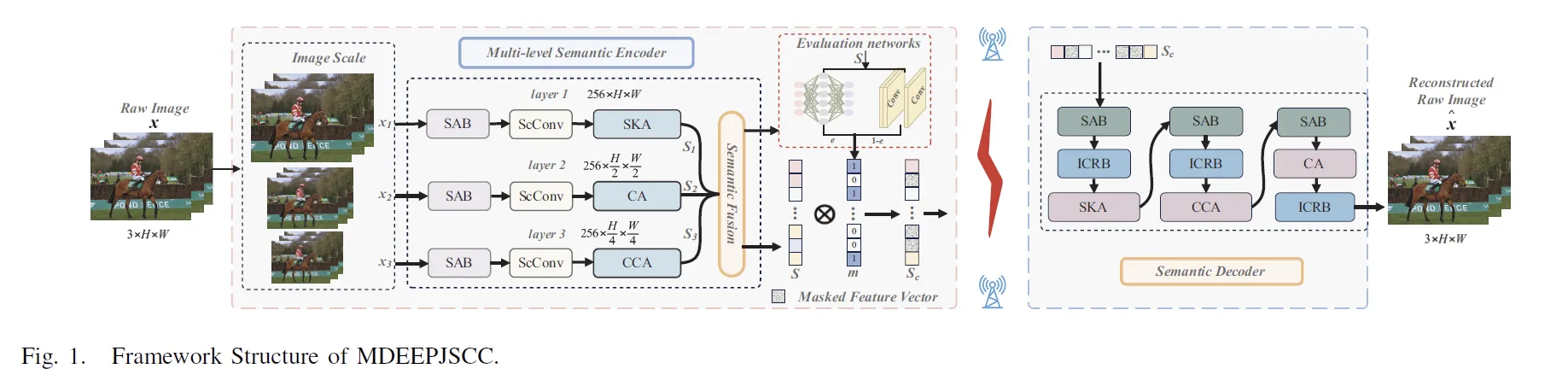

总体框架图如上图所示。

总体框架图如上图所示。

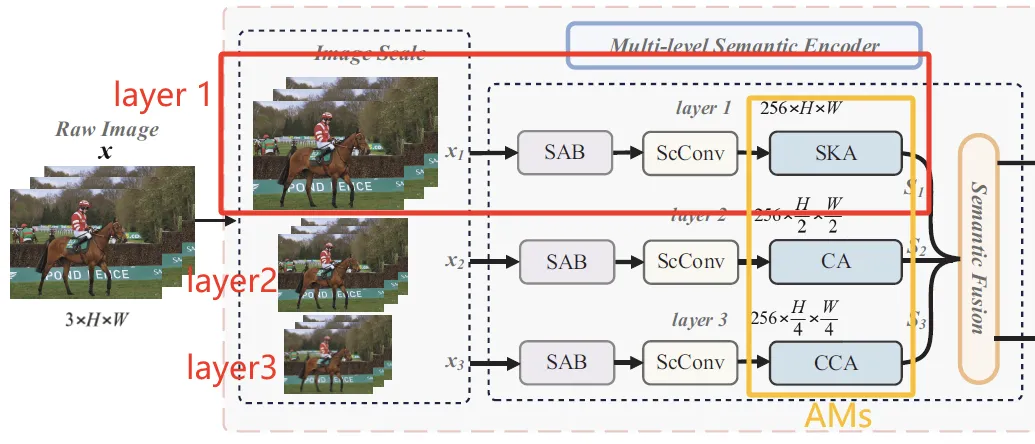

1. Multi-level Semantic Extractor 多尺度语义提取

采用三层的结构分层提取语义信息,每层的结构如下:

image scale --> SAB --> ScConv --> AM -->

| 层 | 组成 | 作用 |

|---|---|---|

| SAB | 全称SNR Adaptive Block | enable the system to adapt to various channel SNR conditions |

| ScConv | a Spatial Reconstruction Unit (SRU) and a Channel Reconstruction Unit (CRU) | reduce feature redundancy in standard convolution while achieving performance improvements && help subsequent AMs to learn more representative semantic features, thus improving the quality of semantic understanding and extraction |

| AM | 包括SK CA CCA |

最终,S_i融合生成S_a,并把S_a展平后生成S。

2. Adaptive Mask Module 自适应掩码模型

使用一系列的卷积神经网络和全连接神经网络评估于一重要性,并分别生成F_a和F_c矩阵,最终语义信息的分数。

W_f从大到小降序排列,取前k个语义,令其掩码策略m[j]=1;后面的m[j]=0。

最终传输的语义信息

3. Semantic Decoder 语义解码器

解码器将继续利用编码器中的AM和SAB,以达到更好的重建质量。同时,引入ICRB(inverse convolutional residual block)进行上采样。

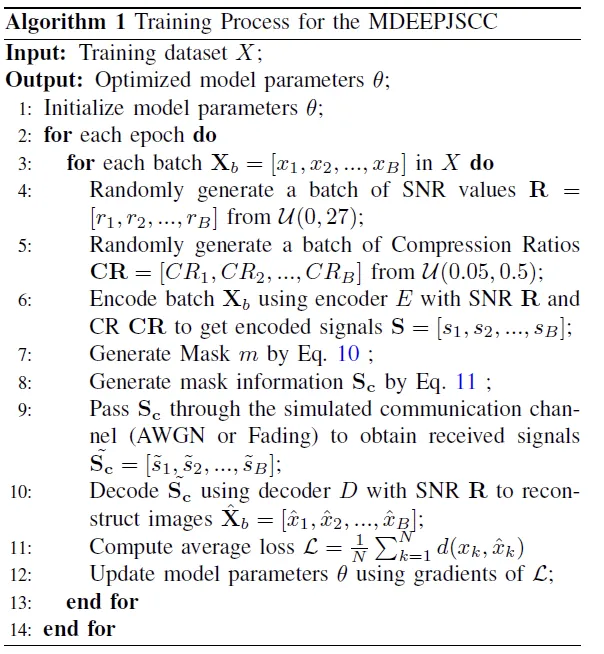

4. 训练算法

本文作者:Travis

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 Travis 许可协议。转载请注明出处!

目录